L’Association for Computational Linguistics (ACL) est la première société internationale, scientifique et professionnelle, regroupant les personnes travaillant sur des problèmes informatiques impliquant le langage humain, un domaine généralement appelé linguistique informatique ou traitement du langage naturel (TLN).

Le TLN est l’étude scientifique du langage d’un point de vue informatique. Les linguistes informatiques s’intéressent à la conception de modèles informatiques de divers types de phénomènes linguistiques. Ces modèles peuvent être « basés sur la connaissance » (« faits-main ») ou « guidés par les données » (« statistiques » ou « empiriques »).

Les activités de l’ACL comprennent l’organisation d’une réunion annuelle chaque été et le parrainage du journal Computational Linguistics, publié par MIT Press ; cette conférence et ce journal sont les principales publications du domaine.

Cette année, la 60e réunion annuelle s’est déroulée du 22 au 27 mai 2022 sous format hybride, à Dublin et en ligne. Les chercheurs de DSAIDIS y ont présenté quatre articles :

2022|The 60th Annual Meeting of the Association for Computational Linguistics

Le 22 novembre s’est tenu à Télécom Paris une réunion Meetup dont le but était de mettre en relation les partenaires industriels et les étudiants de la chaire DSAIDIS.

Après une session de présentation des différents partenaires qui accompagnent la chaire dans ses activités, les doctorant.e.s et post-doctorant.e.s ont eu l’occasion d’échanger en plus petit comité dans des salles dédiées.

13h45 Accueil

14H00 Présentation des partenaires industriels

14h15 Installation des équipes au 5e – rencontre partenaires / étudiants, postdocs

15h30 Pause café

15h45 Rencontre partenaires / étudiants, postdocs

17H00 Fin

Le mardi 15 novembre s’est tenu l’atelier « Optimization and neural networks » de la chaire DSAIDIS. Des membres permanents et des doctorants ont présenté à cette occasion leurs travaux de recherche.

Olivier Fercoq

[EN] I will present the ADAM algorithm, which is a famous stochastic gradient method with adaptive learning rate. It is based on exponential moving averages of the stochastic gradients and their squares in order to estimate the first and second moments.

Then I will explain the main ideas of its convergence proof in the case of a convex objective function. The challenges are the following: 1) the estimation of the first moment is biased; 2) the learning rate is a random variable. They are solved by finding terms that telescope almost surely and by using the fact that learning rate is small when the gradient estimate is noisy.

Maxime Lieber

[EN] In this talk, we revisit the tuning of the spectrogram window length, making the window length a continuous parameter optimizable by gradient descent instead of an empirically tuned integer-valued hyperparameter.

We first define two differentiable versions of the STFT w.r.t. the window length, in the case where local bins centers are fixed and independent of the window length parameter, and in the more difficult case where the window length affects the position and number of bins. We then present the smooth optimization of the window length with any standard loss function. We show that this optimization can be of interest not only for any neural network-based inference system, but also for any STFT-based signal processing algorithm. We also show that the window length can not only be fixed and learned offline, but also be adaptive and optimized on the fly. The contribution is mainly theoretical for the moment but the approach is very general and will have a large-scale application in several fields.Enzo Tartaglione

[EN] Recent advances in deep learning optimization showed that, with some a-posteriori information on fully-trained models, it is possible to match the same performance by simply training a subset of their parameters which, it is said, « had won at the lottery of initialization ».

[EN] Recent advances in deep learning optimization showed that, with some a-posteriori information on fully-trained models, it is possible to match the same performance by simply training a subset of their parameters which, it is said, « had won at the lottery of initialization ».

Hicham Janati

La journée s’est terminée sur une discussion autour des données et de l’IA frugale.

La Neural Information Processing Systems Foundation est une société à but non lucratif qui a pour objectif de favoriser l’échange de recherches sur les systèmes de traitement d’information neuronale dans leurs aspects biologique, technologique, mathématique et théorique. Le traitement de l’information neuronale est un domaine qui tire parti d’une vision combinée des sciences biologiques, physiques, mathématiques et informatiques.

Le principal objectif de la Fondation est de présenter une série continue de réunions professionnelles appelées Neural Information Processing Conference ou NeurIPS, au fil des ans à divers endroits aux États-Unis, au Canada et en Espagne. L’édition 2022 aura lieu du 28 novembre au 9 décembre, au Palais des Congrès Ernest N. Morial de La Nouvelle-Orléans, États-Unis.

Cette année, 7 publications de la chaire DSAIDIS ont été acceptées :

ICML, Conférence internationale sur l’apprentissage statistique, est le premier rassemblement de professionnels dédié à l’avancement de cette branche de l’intelligence artificielle appelée aussi apprentissage automatique ou machine learning.

ICML est mondialement réputé pour la présentation et la publication de travaux de recherche de pointe sur tous les aspects de l’apprentissage utilisés dans des domaines étroitement liés tels que l’intelligence artificielle, les statistiques et la science des données, ainsi que dans d’importants domaines d’application tels que la vision artificielle, la biologie informatique, la reconnaissance de la parole ou la robotique.

ICML est l’une des conférences sur l’IA dont la croissance est la plus rapide au monde. Elle accueille des participants d’horizons très divers, des chercheurs universitaires et industriels aux entrepreneurs et ingénieurs, en passant par les étudiants et les post-doctorants.

Cette année, elle s’est tenue à Baltimore, Maryland USA, du 17 au 23 Juillet. Les chercheurs de la chaire DSAIDIS y ont présenté trois articles :

Functional Output Regression with Infimal Convolution: Exploring the Huber and ϵϵ-insensitive Losses [Arxiv]

Alex Lambert (KU Leuven) · Dimitri Bouche (Télécom Paris) · Zoltan Szabo (Ecole Polytechnique) · Florence d’Alché-Buc (Télécom Paris, Institut Polytechnique de Paris)

Learning to Predict Graphs with Fused Gromov-Wasserstein Barycenters [Arxiv]

Luc Brogat-Motte (Télécom Paris) · Rémi Flamary (École Polytechnique) · Celine Brouard (INRAE) · Juho Rousu (Aalto University) · Florence d’Alché-Buc (Télécom Paris, Institut Polytechnique de Paris)

Mitigating Gender Bias in Face Recognition using the von Mises-Fisher Mixture Model [Arxiv]

Jean-Rémy Conti (Télécom Paris Idemia) · Nathan NOIRY (Telecom Paris) · Vincent Despiegel (Idemia) · Stéphane Gentric (IDEMIA) · Stephan Clemencon (Telecom ParisTech)

2022|The Thirty-ninth International Conference on Machine Learning.

Le mercredi 15 juin s’est déroulé la journée de la chaire DSAIDIS. Cet événement annuel est une opportunité pour l’équipe de Télécom Paris de rencontrer les équipes opérationnelles des cinq entreprises partenaires : Airbus, ENGIE, IDEMIA, Safran et Valeo. À cette occasion, différents membres de l’équipe académique, des enseignants-chercheurs aux doctorants, ont présenté leurs travaux articulés selon les quatre grands axes de la chaire. De nombreux moments de convivialité étaient également prévus pour favoriser les échanges.

9h – 9h30 – Café de bienvenu et Introduction > Retrouvez le support d’introduction 9h30 – 10h50 – Axe 2 : Exploitation à grande échelle de données partiellement étiquetées et hétérogènes > Retrouvez les supports et le replay vidéo des présentations de l’Axe 2 10h50 – 11h10 Pause Café 11h10 – 12h35 – Axe 1 : Analyse et prévision de séries temporelles > Retrouvez les supports et le replay vidéo des présentations de l’Axe 1 12h35 – 14h Déjeuner 14h – 15h20 – Axe 4 : Apprentissage en interaction avec l’environnement > Retrouvez les supports et le replay vidéo des présentations de l’Axe 4 15h20 – 15h40 Pause Café 15h40 – 17h – Axe 3 : Apprentissage statistique au service d’une prise de décision fiable et robuste > Retrouvez les supports et le replay vidéo des présentations de l’Axe 3 17h-17h15 – Discussion et conclusion

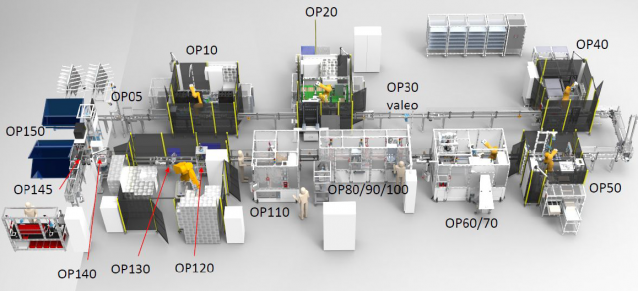

L’un des objectifs de la chaire Data Science & Artificial Intelligence for Digitalized Industry & Services (DSAIDIS) de Télécom Paris est de favoriser les connexions et l’échange entre les milieux industriel et académique. Depuis quelques années, Valeo, partenaire industriel de la chaire, utilise son site de l’Isle d’Abeau comme pilote pour expérimenter avec les équipes de DSAIDIS la valorisation des données issues des lignes de production. Le projet Start2 fait partie de ces opportunités de mutualisation des expériences où la data science a permis de diviser par deux le taux de défectuosité des pièces aux tests finaux. Pavlo Mozharovskyi, maître de conférences à Télécom Paris et chercheur au sein de DSAIDIS, et Éric Manouvrier, data analyst et Master expert en LEAN 6 sigma chez Valeo, reviennent sur cette collaboration réussie.

Quelle a été l’origine de votre collaboration sur ce projet ?

Pavlo Mozharovskyi : Florence (D’Alché-Buc, porteuse de la chaire DSAIDIS) et moi avions travaillé avec une autre équipe de Valeo sur un projet appelé Expresso. Malheureusement le jeu de données issu de cette ligne de production n’a pas permis d’exploiter autant que souhaité nos travaux sur la détection d’anomalies et le projet a été fermé en décembre 2020.

Éric Manouvrier : À la suite de ça, la direction de Valeo m’a demandé de fournir un jeu de données issu d’une autre ligne de production, Start2. C’est ainsi qu’a démarré en 2021 un nouveau travail de collaboration avec Florence et Pavlo, dans la lignée de ce qui avait été initié avec Expresso.

Qu’est-ce qui a évolué entre ces deux projets Expresso et Start2 ?

PM: Pour nous, ce projet s’inscrit vraiment dans la continuité du précédent. Nous avons tout de même agrandi l’équipe et recruté un ingénieur, Arturo Castellanos Salinas, pour travailler spécifiquement sur Start2. Mais le changement vient surtout de la ligne de production d’où proviennent les données, et de la collaboration avec une nouvelle équipe chez Valeo, menée par Eric.

EM: De notre côté, une des innovations majeures a été la découverte d’un environnement de traçabilité de la qualité pour y faire de la performance. Avant, nous ne nous intéressions aux données qu’en cas de problème qualité, en regardant a postériori les caractéristiques d’une pièce défectueuse. Or sur ces projets, nous explorons les données pour optimiser le réglage des stations de travail et réduire les mauvaises pièces en sortie de ligne. Le projet Expresso nous a fait prendre conscience de la nécessité d’avoir un jeu de données de qualité, ce qui est difficile à obtenir pour des tas de raisons. Sur Start2, nous avons donc passé du temps à structurer un jeu de données beaucoup plus riche pour alimenter les algorithmes développés par Télécom Paris.

Quels outils ont été mis en place pour analyser ces données ?

PM: Nous avons développé une méthodologie statistique en plusieurs parties dont la première est la visualisation. C’est une étape très importante car la visualisation permet de comprendre les données, elle représente quasiment la moitié du travail. Pour cela, nous avons déployé différents outils. Le premier est la représentation temporelle des paramètres de production. Nous avons à la fois regardé l’évolution d’un même paramètre au cours du temps, en suivant l’apparition d’anomalies en fonction de la valeur de ce paramètre, et à la fois comparé plusieurs paramètres sur une même échelle de temps pour comprendre leur dépendance statistique. Le deuxième outil est la représentation du flux physique des pièces sous forme de diagramme « spaghetti », où chaque « spaghetti » correspond au parcours d’une pièce dans la ligne de production. Ce type de diagramme permet de constater si les lignes fonctionnent correctement ou s’il y a des retards à certains niveaux. Les retards sont visualisés par des trous dans les lignes de passage des pièces. Nous cherchions donc à obtenir un diagramme bien rempli, signifiant qu’il n’y a pas de perte de temps et donc pas de perte d’argent.

EM : Nous pensions que la solution viendrait des algorithmes de machine learning mais c’est finalement la visualisation qui a été clé dans la réussite de ce projet.

PM : Nous avons aussi déployé des méthodes statistiques pour observer le fonctionnement de la ligne, et notamment, sur les derniers mois du projet, nous avons utilisé une méthode de binning afin de visualiser à l’aide de régressions et de tests statistiques la dépendance entre les paramètres.

Quelles conclusions avez-vous tirées de l’utilisation de ces différents outils et quelles actions avez-vous mis en place ?

EM : Grâce à la visualisation des paramètres de production, nous avons identifié ceux qui étaient décisifs pour éviter les défauts sur le banc de test. Cela a été confirmé par le binning, ce qui nous a conforté dans notre décision d’essayer un nouveau réglage. Lorsque nous l’avons fait, le taux de défauts a été immédiatement divisé par deux ! Cela faisait quatre ans que nous n’avions pas observé une telle rupture dans le taux de rejet. Nos équipes de production ont été bluffées de voir que des personnes extérieures étaient capables d’identifier les sources d’anomalies et de suggérer un changement de réglage qui fonctionne.

Qu’est-ce qui a fait le succès de ce projet, et de votre collaboration en particulier ?

EM : Quasiment toutes les semaines, nous faisions le point sur ce qui était en cours, à faire, sur les conclusions tirées des graphiques… Cette « ritualisation » de notre méthode de travail a favorisé les échanges et facilité la résolution d’une multitude de petits problèmes, notamment au niveau de l’extraction des données.

PM : Nous avons beaucoup appris des deux côtés. Nous sommes avant tout des académiques, pas des industriels, donc nous avons aussi tâtonné pour aider à améliorer la qualité de ces données issues de lignes de production. Nous avons donné des consignes au fur et à mesure et l’équipe Valeo a été très réactive, ce qui nous a permis de poursuivre nos travaux de façon efficace.

EM : Globalement, ce qui a fonctionné sur ce projet, c’est le travail en équipe avec des gens qualifiés. Du côté de Valeo, l’équipe mise en place associait à la fois des experts métiers, un responsable et un superviseur de production pour donner du sens à la donnée, et des data scientists dont je fais partie, c’est-à-dire des profils polyvalents qui comprennent les données et le terrain. L’ensemble du dispositif a été sponsorisé par un directeur industriel, Romain Bruniaux, qui a participé en personne à certaines réunions techniques. L’implication de la direction dans ce type de projet novateur est indispensable. Il a fallu la conviction de la direction des deux partenaires – Florence d’Alché-Buc chez Télécom Paris et Romain Bruniaux chez Valeo – pour doter le projet en ressources humaines, techniques, financières… En retour, le succès qui remonte du terrain est un facteur clé pour la scalability, c’est-à-dire le passage à l’échelle.

Quelles sont les suites envisagées pour ce projet ?

EM : Après le changement de réglage, nous avons continué un peu les développements, mais sans trouver plus d’optimisations. Nous avons fermé le projet Start2 et avons tout de suite poursuivi avec un nouveau cas d’usage actuellement en cours pour accompagner le lancement d’un nouveau produit, toujours sur le site de Saint-Quentin Fallavier. Avec ce projet, nous passons à l’échelle supérieure puisque quatre lignes de production sont concernées. Nous avons également renforcé notre collaboration par le recrutement conjoint d’un doctorant dédié à ce sujet. Nous avons co-écrit le sujet de thèse avec les équipes de Télécom Paris et sélectionné ensemble le candidat, pour son profil à l’interface de la recherche et de l’industrie.

On peut donc imaginer de nombreux autres projets entre Valeo et Télécom Paris pour l’avenir ?

EM : Aujourd’hui le moteur de notre collaboration avec Télécom Paris ce sont les résultats. Le fait d’avoir des bons résultats sur des cas d’usage – résoudre des problèmes qualité, produire plus de pièces, supprimer les aléas quotidiens en production, etc. – crédibilise la démarche d’une collaboration de recherche en data science avec une école. Plus on améliore la production et plus on va ouvrir des chantiers de data science qui vont eux-mêmes engendrer des résultats. Tout cela forme un cercle vertueux.

Depuis sa création en 1985, la conférence internationale AISTATS est un rassemblement interdisciplinaire de chercheurs au croisement de l’intelligence artificielle, de l’apprentissage automatique, des statistiques et des domaines connexes.

Lors de cette 25e édition, qui s’est tenue cette année encore en ligne, du 28 au 30 mars, l’équipe de la chaire DSAIDIS a présenté deux articles :

Plus d’information sur la conférence AISTATS

Pierre Colombo a reçu au cours de la 36e Conférence AAAI sur l’intelligence artificielle le prix Outstanding Student Paper pour sa publication « InfoLM: A New Metric to Evaluate Summarization & Data2Text Generation ». Cette nouvelle catégorie, ajoutée en 2022, vient distinguer son travail effectué en tant que post-doctorant au sein de la chaire DSAIDIS, sous la supervision de Chloé Clavel.

P. Colombo, C. Clavel, and P. Piantanida, « InfoLM: A New Metric to Evaluate Summarization & Data2Text Generation. », AAAI (2022).